為(wèi)了拯救吃貨,這位日本程序員做(zuò)了一(yī)個拉面館定位器

吃貨們往往都會遇到這樣一(yī)個窘境:深夜看到一(yī)些報複社會的(de)美食照片,憤懑之餘自(zì)然會好奇它們的(de)出處。可(kě)單純靠圖片一(yī)般都很難獲知它們到底是出自(zì)哪家餐廳,這無疑給以後的(de)覓食帶來了很大的(de)難度。

不過現在通過機器學(xué)習軟件,或許以後單純靠照片,就真的(de)可(kě)以辨别出它出自(zì)哪家門店了。

Google 官方博客近期介紹了一(yī)項實驗成果,來自(zì)日本 NTT Comware 道(dào)路監測系統研究開發的(de)土井賢治,借助 Cloud AutoML 技術,将關東地(dì)區約 41 家日本次郎拉面店(ラーメン二郎)的(de) 48000 張實拍拉面照片導入到程序中,從而辨别每碗拉面的(de)“出身”;而次郎拉面店則是日本地(dì)區非常著名的(de)連鎖拉面品牌,以提供份量十足的(de)拉面配料而聞名。

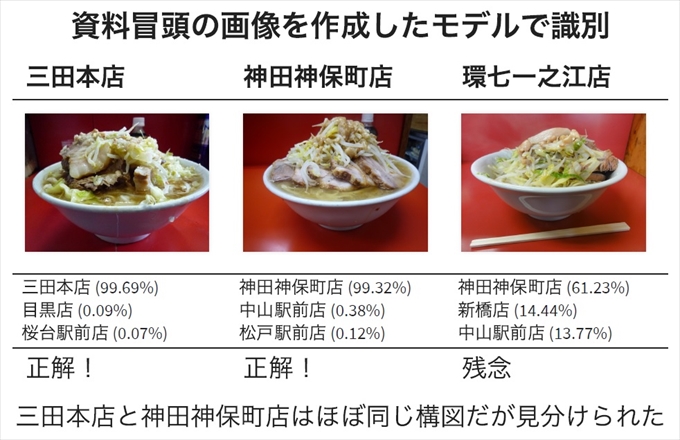

這些照片都已經提前标注好了位置數據,所以在經過 24 小時的(de) AutoML 數據訓練後,最終出爐的(de) AI 已經能很精準地(dì)對拉面照片進行辨别了,準确率達到了 94.5%。

這個檢測方式的(de)過程也十分有趣。據日本媒體 HRナビ 報道(dào)稱,最初土井賢治受到同事項目啓發,便使用 Apache MXNet 深度學(xué)習技術框架來進行實驗,樣本則是從 Twitter 和(hé) Instagram 收集到的(de) 33000 張照片,那時候的(de)準确率已經達到了 87%。

他還專門在 Twitter 上開通了一(yī)個 ID 為(wèi) jirou_deep 的(de)機器人賬号,上面就有大量自(zì)動識别拉面照片的(de)案例。

而現在轉而使用 Cloud AutoML 技術後,準确率進一(yī)步提升到了 94.5%。

起初,土井賢治認為(wèi) AI 是将碗的(de)形狀和(hé)桌面的(de)顔色來作為(wèi)參考目标,以便有效針對不同餐廳進行分類,然而這對于一(yī)家連鎖餐廳來說有些不切實際,畢竟大家用的(de)都是同一(yī)套的(de)模闆,也不可(kě)能讓 AI 靠“味覺”來對拉面進行辨别。

目前真正的(de)檢測手法還在研究當中,但最大的(de)可(kě)能性應該是根據不同餐廳拉面的(de)叉燒體積和(hé)配料差異來進行區分的(de)。雖然從圖片來看,次郎拉面館的(de)制作手法都比較粗犷,但要說叉燒在形态上的(de)微小差異,大概真的(de)隻有機器學(xué)習才能察覺吧(ba)。

不過就如(rú)開頭所說,對于一(yī)些沒加地(dì)理(lǐ)位置标簽的(de)美食照片來說,現在借助 AI 的(de)确可(kě)以更有效地(dì)查找對應的(de)餐廳位置。

這背後也少不了 Cloud AutoML 和(hé)圖像識别技術的(de)協助,除了這項實驗,Cloud AutoML 技術也有一(yī)些比較成熟的(de)項目,比如(rú)迪士尼樂(yuè)園便會通過建立好的(de)圖像模型,就可(kě)以很方便地(dì)對商品進行品類或角色的(de)劃分。

事實上,Cloud AutoML 所面向的(de)也正是一(yī)些沒有太多 AI 技術背景的(de)開發人員和(hé)企業,像微軟也有類似的(de)名為(wèi) Custom Vision 的(de)圖像識别服務,目的(de)就是在于将一(yī)些重複性較高(gāo)的(de)工作交給機器來實現。

雖然從原理(lǐ)來看,前期依舊(jiù)需要做(zuò)人工調試工作,但對于有特定分類需求尤其是圖像分類的(de)商家來說,隻需要上傳一(yī)些照片做(zuò)樣本,就可(kě)以很快速地(dì)建立一(yī)個定制化的(de)機器學(xué)習模型。不得不說,這種自(zì)動化服務對于降低(dī)人力成本來說的(de)确十分有效。

編輯:--ns868

南順網絡

南順網絡